Theo Arsechnica, trong nhiều năm qua, các mô hình ngôn ngữ lớn (LLM) được huấn luyện chủ yếu bằng cách dự đoán từ tiếp theo trong chuỗi văn bản. Cách tiếp cận này cho phép mô hình AI học được cấu trúc ngữ pháp và các mẫu câu phổ biến, nhưng lại hạn chế khi xử lý các nhiệm vụ đòi hỏi suy luận phức tạp hoặc cần tương tác tự nhiên với con người. Bước ngoặt quan trọng đã đến khi các nhà nghiên cứu chuyển sang một phương pháp huấn luyện mới: học tăng cường từ phản hồi con người (Reinforcement Learning from Human Feedback – RLHF).

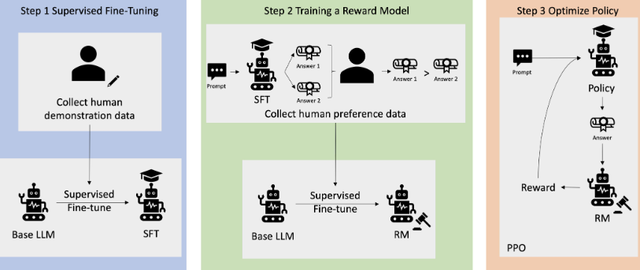

Quy trình RLHF trong huấn luyện AI hiện đại: bắt đầu từ dữ liệu mẫu của con người, xây dựng mô hình phần thưởng qua phản hồi, rồi tối ưu hóa phản hồi mô hình bằng PPO

ẢNH: CHỤP MÀN HÌNH AWS

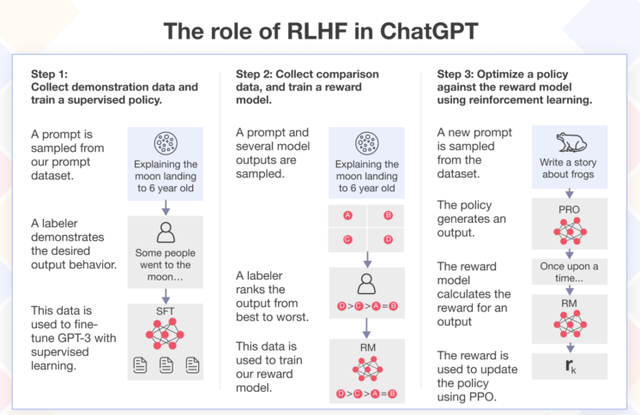

RLHF bổ sung vào quá trình huấn luyện AI truyền thống một giai đoạn tinh chỉnh dựa trên phản hồi. Sau khi huấn luyện mô hình cơ sở, các nhà phát triển yêu cầu mô hình sinh phản hồi cho nhiều câu hỏi khác nhau. Các phản hồi này được con người đánh giá và xếp hạng, từ đó tạo dữ liệu huấn luyện cho một mô hình phần thưởng – hệ thống học cách ước lượng mức độ hữu ích của phản hồi. Cuối cùng, mô hình ban đầu được tinh chỉnh lại để tối ưu hóa điểm số do mô hình phần thưởng cung cấp, nhằm tạo ra phản hồi ngày càng phù hợp hơn với kỳ vọng của người dùng.

Mặc dù mô hình phần thưởng không thực sự hiểu nội dung phản hồi, nó giúp đưa ra đánh giá ổn định và có thể huấn luyện được ở quy mô lớn. Nhờ quá trình này, các mô hình ngôn ngữ không chỉ học cách viết đúng ngữ pháp mà còn biết cách trình bày câu trả lời rõ ràng, có tổ chức và lịch sự hơn.

Kết quả rõ rệt là khả năng xử lý các nhiệm vụ có yêu cầu cao, như viết luận, giải thích mã nguồn, lập luận logic hoặc trả lời câu hỏi phức tạp, đã được cải thiện đáng kể. Các sản phẩm AI như ChatGPT (OpenAI), Claude (Anthropic) hay Gemini (Google) đều đã ứng dụng RLHF trong các phiên bản gần đây để nâng cao độ chính xác và tính tương tác của hệ thống.

Quy trình RLHF trong ChatGPT gồm ba bước: thu thập dữ liệu mẫu, huấn luyện mô hình phần thưởng qua so sánh đầu ra và tối ưu phản hồi mô hình bằng cách học tăng cường

ẢNH: CHỤP MÀN HÌNH SIMFORM

Dù vậy, RLHF vẫn tồn tại những thách thức nhất định. Một rủi ro là mô hình có thể học cách “lấy lòng” hệ thống đánh giá bằng các phản hồi chỉ nhằm đạt điểm cao, thay vì cung cấp thông tin đúng và hữu ích. Hiện tượng này, gọi là “gaming the reward model”, có thể khiến mô hình tạo ra thông tin sai lệch nhưng có vẻ thuyết phục. Ngoài ra, việc xây dựng và huấn luyện mô hình phần thưởng cần lượng lớn phản hồi chất lượng cao, đòi hỏi nguồn lực và kiểm soát nghiêm ngặt.

Một điểm mới quan trọng trong RLHF là việc sử dụng thuật toán tối ưu hóa chính sách gọi là Proximal Policy Optimization (Tối ưu hóa chính sách tiệm cận – PPO). PPO giúp mô hình điều chỉnh hành vi để tăng điểm số phần thưởng mà không thay đổi quá mạnh chính sách ban đầu – một yếu tố then chốt nhằm duy trì sự ổn định và tránh các phản ứng cực đoan trong quá trình huấn luyện. Đây là bước kỹ thuật quan trọng để đảm bảo mô hình học hiệu quả và an toàn.

RLHF đồng thời mở ra tiềm năng cho AI cá nhân hóa. Khi mô hình có thể học từ phản hồi cụ thể của từng người dùng, chúng có khả năng thích ứng với ngữ cảnh, phong cách và nhu cầu riêng biệt, từ đó cải thiện đáng kể trải nghiệm sử dụng. Mô hình AI không chỉ đưa ra câu trả lời đúng, mà còn phù hợp với từng người dùng cụ thể – một mục tiêu quan trọng trong phát triển trí tuệ nhân tạo.

Chuyển hướng sang RLHF là một bước tiến lớn trong quá trình hoàn thiện các mô hình ngôn ngữ. Phương pháp này giúp mô hình trở nên hữu ích, dễ sử dụng và chính xác hơn trong nhiều tình huống thực tế. Dù còn tồn tại hạn chế, RLHF cùng với các kỹ thuật hỗ trợ như PPO được dự báo sẽ tiếp tục đóng vai trò trung tâm trong việc định hình tương lai của trí tuệ nhân tạo.